Aronszajnというカーネルの数学者の結果です。「機械学習のためのカーネル 100問」の3.1節に掲載していますが、少しくだいてみました。テキストを最初から読んでいるか、関数解析を勉強したことのある人なら理解できると思います。

$H_1,H_2$をHilbert空間としたときに、その直積

$F:=H_1\times H_2$は、内積

$$

\langle (f_1,f_2),(g_1,g_2)\rangle_F := \langle f_1,g_1\rangle_{H_1}+\langle f_2,g_2\rangle_{H_2}, \hspace{5mm}

f_1,g_1\in H_1,\hspace{5mm} f_2,g_2\in H_2

$$のもとで、Hilbert空間になります。実際、$\|f_{1,n}-f_{1,m}\|_{H_1}$, $\| f_{2,n}- f_{2,m}\|_{H_2}$が

$$\hspace{3mm}\sqrt{\|f_{1,n}-f_{1,m}\|_{H_1}^2+\| f_{2,n}- f_{2,n}\|_{H_2}^2}=\|(f_{1,n},f_{2,n})-(f_{1,m},f_{2,m})\|_{F}

$$以下であることを用いると、以下が成立します。

$\{(f_{1,n},f_{2,n})\}$がCauchy $\Longrightarrow $ $\{f_{1,n}\}$, $\{f_{2,n}\}$がCauchy

$\Longrightarrow $ $\{f_{1,n}\}$, $\{f_{2,n}\}$がある$f_1\in H_1,f_2\in H_2$に収束

$\Longrightarrow $ $\|(f_{1,n},f_{2,n})-(f_{1},f_{2})\|_F= \sqrt{\|f_{1,n}-f_{1}\|^2+\|f_{2,n}-f_{2}\|^2}\rightarrow 0$

$\Longrightarrow $ $\{(f_{1,n},f_{2,n})\}$が$(f_1,f_2)\in F$に収束

すなわち、$H_1$,$H_2$が完備なら、$F$も完備です。

次に、$H_1,H_2$の直和

$H:=H_1 + H_2:=\{f_1+f_2|f_1\in H_1,f_2\in H_2\}$について考えます。$F$を写像$$u: F\ni (f_1,f_2)\mapsto f_1+f_2\in H$$の核$N:=\{(f_1,f_2)\in F|f_1+f_2=0\}$と、その直交補空間$N^\perp:=\{x\in F\mid \langle x,y\rangle=0, y\in N\}$に分解すると、$$N\cap N^\perp=\{(0,0)\}$$が成立します。ここで、$u$を$N^\perp$に制限した$v: N^\perp \rightarrow H$は単射$$v(f_1,f_2)=v(f_1′,f_2′)\Longrightarrow (f_1,f_2)=(f_1′,f_2′)$$になります。実際、$f_1+f_2=f_1’+f_2’$かつ$(f_1,f_2),(f_1′,f_2′)\in N^\perp$であれば、$$(f_1-f_1′,f_2-f_2′)\in N^\perp$$が成立します。他方、$f_1+f_2=v(f_1,f_2)=v(f_1′,f_2′)=f_1’+f_2’$は、$$(f_1-f_1′,f_2-f_2′)\in N$$を意味し、両者より、$(f_1-f_1′,f_2-f_2′)=(0,0)$が成立します。

$H=H_1+H_2$が以下の内積をもつとき、$H$は完備(Hilbert空間)となります。$$\langle f,g\rangle_H:=\langle v^{-1}(f),v^{-1}(g)\rangle_F\ ,\hspace{5mm}f,g\in H$$実際、$F$がHilbert空間で、$N^\perp$はその閉部分空間(テキスト命題20の1)ですから、$N^{\perp}$は完備となり、$\|f_n-f_m\|_H\rightarrow 0 \Longleftrightarrow \|v^{-1}(f_n-f_m)\|_F\rightarrow 0$

$\Longrightarrow$ $\|v^{-1}(f_n)-g\|_F\rightarrow 0$なる$g\in N^\perp$が存在$\Longrightarrow $ $\|f_n-v(g)\|_H\rightarrow 0$が成立します。

$H_1$, $H_2$が再生核$k_1,k_2$をもつとき、上記のように定義されたHilbert空間$H:=H_1 + H_2$は、$k_1+k_2$を核とするRKHSになります。この証明は(難しくありません)、テキストの付録を参照してください。

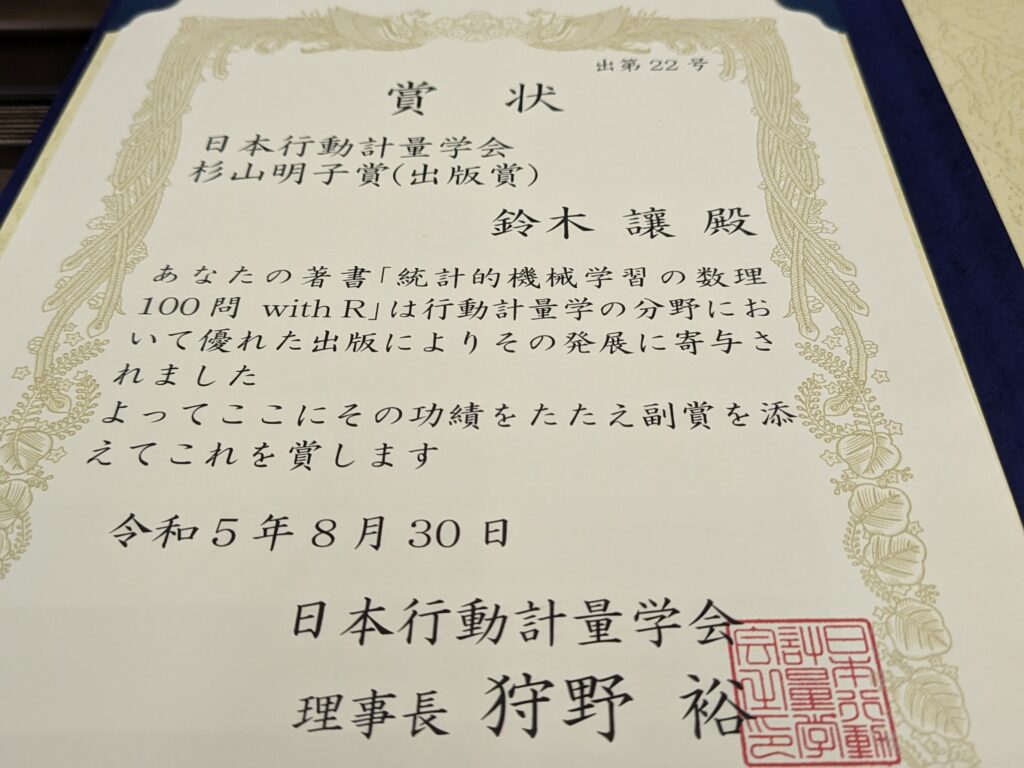

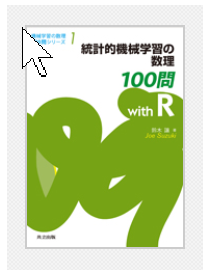

数学で記述できます。「統計的機械学習の数理100問with R」は、数学の各段階をソースコードで正確に書いて、動作を確認しています。このようにすると、自然と数学的なロジックもついてきて、データサイエンスに必要な本質を見る姿勢ができてきます。業務でパッケージを用いることは否定しません。しかし、勉強の段階では、ブラックボックスにしないで、動作を確認すべきです。そして、正しい結論を世の中に提供するという本来の使命を果たすべきだと思っています。

数学で記述できます。「統計的機械学習の数理100問with R」は、数学の各段階をソースコードで正確に書いて、動作を確認しています。このようにすると、自然と数学的なロジックもついてきて、データサイエンスに必要な本質を見る姿勢ができてきます。業務でパッケージを用いることは否定しません。しかし、勉強の段階では、ブラックボックスにしないで、動作を確認すべきです。そして、正しい結論を世の中に提供するという本来の使命を果たすべきだと思っています。